Den ökande investeringen i AI-agenter pekar mot en framtid med omfattande automation, potentiellt mer omvälvande än den industriella revolutionen. Precis som med all teknisk innovation kommer AI-agenter att stöta på utmaningar under utvecklingen. Kontinuerlig förbättring blir avgörande för ansvarsfull användning och för att nå deras fulla potential.

På Consensus Hong Kong intervjuade BeInCrypto Andrei Grachev, Managing Partner på DWF Labs, om de viktigaste utmaningarna AI-agenter står inför för att nå massanvändning och hur utbredd användning kan se ut.

Traditionella tekniksektorer och Web3 omfamnar AI

Det är nu säkert att säga att antagandet av artificiell intelligens (AI) snart blir oundvikligt. Teknikjättar som Meta, Amazon, Alphabet och Microsoft har redan meddelat planer på att investera upp till 320 miljarder USD i AI och datacenter år 2025.

Under sin första vecka i ämbetet tillkännagav USA:s president Trump Stargate, ett nytt privat samriskföretag fokuserat på utveckling av AI-datacenter. Företaget, som består av OpenAI, Softbank och Oracle, planerar att bygga upp till 20 stora AI-datacenter över hela USA.

Den initiala investeringen beräknas till 100 miljarder USD, och expansionsplaner kan öka totalen till 500 miljarder USD år 2029.

Web3-projekt gör också liknande investeringar i AI. I december lanserade DWF Labs, ett ledande kryptoventurekapitalföretag, en AI-agentfond på 20 miljoner USD för att påskynda innovation inom autonoma AI-teknologier.

Tidigare denna månad meddelade NEAR Foundation, som stöder NEAR-protokollet, sin egen fond på 20 miljoner USD fokuserad på att skala utvecklingen av helt autonoma och verifierbara agenter byggda på NEAR-teknologi.

“Historien visar att allt som kan automatiseras kommer att automatiseras, och definitivt kommer vissa affärs- och vardagsprocesser att övertas av AI-agenter,” sa Grachev till BeInCrypto.

Men när AI-utvecklingen accelererar blir risken för missbruk en växande oro.

Skadlig användning av AI-agenter

Inom Web3 blir AI-agenter snabbt vanliga. De erbjuder olika möjligheter, från marknadsanalys till autonom kryptohandel.

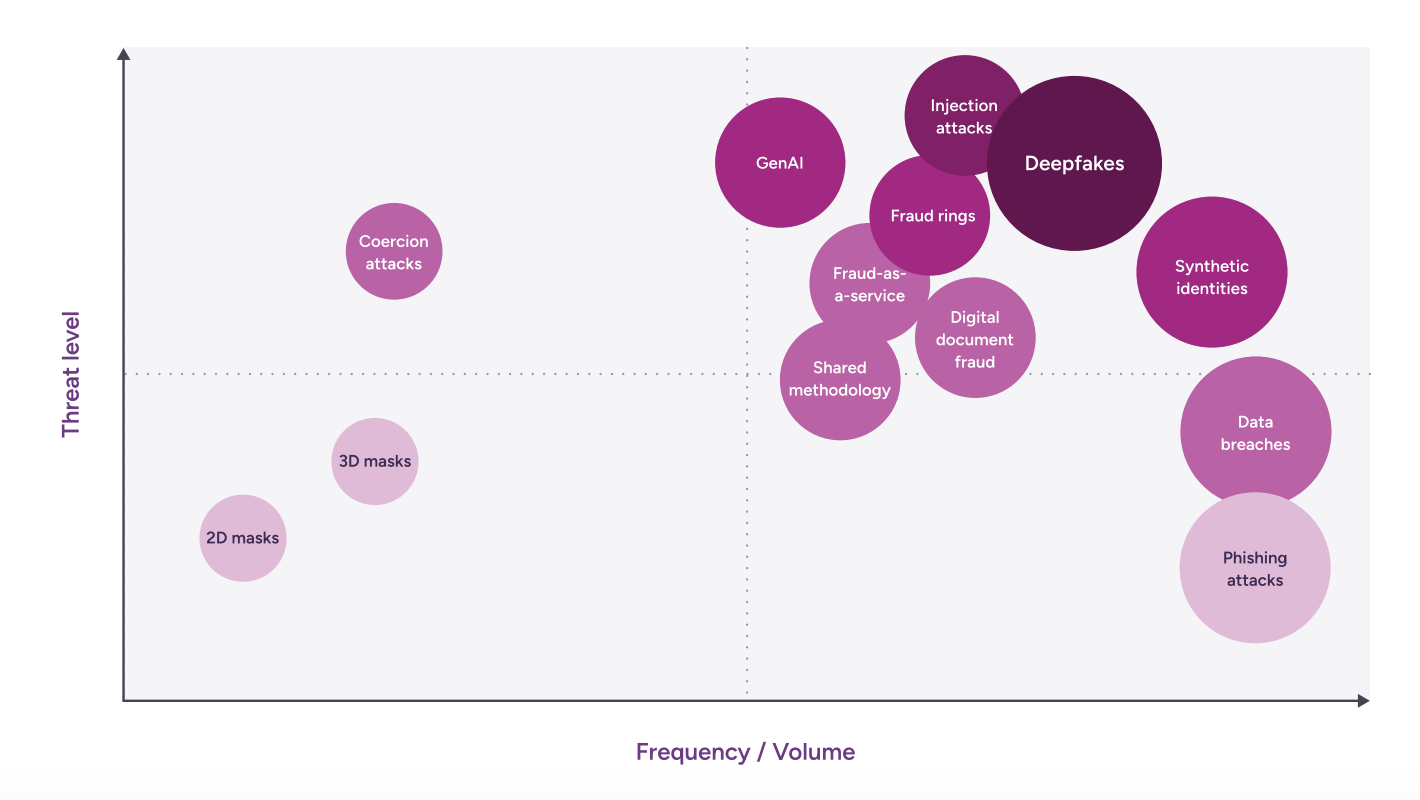

Men deras ökande integration medför också kritiska utmaningar. AI-missbruk av illvilliga aktörer är en stor oro, med scenarier som sträcker sig från enkla nätfiskekampanjer till sofistikerade ransomware-attacker.

Den utbredda tillgängligheten av generativ AI sedan slutet av 2022 har fundamentalt förändrat innehållsskapande samtidigt som det lockar illvilliga aktörer som vill utnyttja teknologin. Denna demokratisering av datorkraft har förbättrat motståndarnas förmågor och potentiellt sänkt tröskeln för mindre sofistikerade hotaktörer.

Enligt en rapport från Entrust överstiger digitala dokumentförfalskningar underlättade av AI-verktyg nu fysiska förfalskningar, med en ökning på 244 % år över år 2024. Samtidigt stod deepfakes för 40 % av all biometrisk bedrägeri.

“Det används redan för bedrägerier. Det används för videosamtal när man felrepresenterar människor och deras röster,” sa Grachev.

Exempel på denna typ av utnyttjande har redan nått nyhetsrubriker. Tidigare denna månad blev en finansarbetare på ett multinationellt företag i Hongkong lurad att godkänna en betalning på 25 miljoner USD till bedragare som använde deepfake-teknologi.

Arbetaren deltog i ett videosamtal med personer han trodde var kollegor, inklusive företagets ekonomichef. Trots initial tvekan fortsatte arbetaren med betalningen efter att de andra deltagarna verkade och lät autentiska, enligt rapporter. Det upptäcktes senare att alla deltagare var deepfake-förfalskningar.

Från tidig adoption till allmän acceptans

Grachev tror att sådana illvilliga användningar är oundvikliga. Han noterar att teknisk utveckling ofta åtföljs av initiala fel, som minskar när teknologin mognar. Grachev gav två tydliga exempel för att bevisa sin poäng: de tidiga stadierna av World Wide Web och Bitcoin.

“Vi bör komma ihåg att internet började med porrsajter. Det var som den första Bitcoin, som började med knarkhandlare och sedan förbättrades,” sa han.

Flera rapporter håller med Grachev. De föreslår att vuxenunderhållningsindustrin spelade en avgörande roll i det tidiga antagandet och utvecklingen av internet. Utöver att tillhandahålla en konsumentbas banade den väg för teknologier som videobandspelare, videostreaming, virtuell verklighet och alla former av kommunikation.

Porr fungerade som ett verktyg för att introducera människor. Vuxenunderhållningsindustrin har historiskt drivit konsumenternas antagande av ny teknologi.

Den tidiga omfamningen och tillämpningen av innovationer, särskilt när de framgångsrikt möter publikens krav, leder ofta till bredare mainstream-antagande.

“Det började med nöje, men nöje introducerade många människor. Sedan kan du bygga något på denna publik,” sa Grachev.

Med tiden infördes skyddsåtgärder för att begränsa frekvensen och tillgängligheten av vuxenunderhållning. Oavsett är det fortfarande en av de flera tjänster internet erbjuder idag.

Bitcoins resa från darknet till förändring

Bitcoins utveckling liknar internets tidiga användningsområden. Bitcoins tidiga användning kopplades starkt till darknet-marknader och olagliga aktiviteter, som narkotikahandel, bedrägeri och penningtvätt. Dess pseudonyma natur och enkelheten i globala överföringar gjorde det attraktivt för brottslingar.

Trots fortsatt användning i brottsliga aktiviteter har Bitcoin många legitima användningsområden. Blockkedjetekniken bakom kryptovalutor löser verkliga problem och förändrar traditionella finansiella system.

Även om de fortfarande är mycket nya, kommer kryptovaluta och blockkedjeapplikationer att fortsätta utvecklas. Enligt Garchev kommer samma sak att hända med gradvis användning av AI-teknik. För honom måste misstag välkomnas för att lära sig av dem och anpassa sig därefter.

“Vi bör alltid komma ihåg att bedrägeri sker först och sedan börjar folk tänka på hur man förhindrar det. Självklart kommer det att hända, men det är en normal process, det är en inlärningskurva,” sa Grachev.

Men att veta att dessa situationer kommer att inträffa i framtiden väcker också frågor om vem som ska hållas ansvarig.

Ansvarsfrågor

Att fastställa ansvar när skada uppstår på grund av en agents handlingar är en komplex juridisk och etisk fråga. Frågan om hur man håller AI ansvarig uppstår oundvikligen.

Komplexiteten i AI-system skapar utmaningar för att fastställa ansvar för skada. Deras “svarta låda”-natur, oförutsägbara beteende och kontinuerliga inlärningsförmåga gör det svårt att tillämpa vanliga idéer om vem som är skyldig när något går fel.

Vidare komplicerar inblandningen av flera parter i AI-utveckling och implementering ansvarsbedömningar, vilket gör det svårt att fastställa skuld vid AI-misslyckanden.

Ansvar kan ligga hos tillverkaren för design- eller produktionsfel, mjukvaruutvecklaren för problem med koden, eller användaren för att inte följa instruktioner, installera uppdateringar eller upprätthålla säkerhet.

“Jag tror att allt är för nytt, och jag tror att vi bör kunna lära oss av det. Vi bör kunna stoppa vissa AI-agenter om det behövs. Men från min synvinkel, om det inte fanns någon ond avsikt att skapa det, är ingen ansvarig för det eftersom det är något riktigt nytt,” sa Grachev till BeInCrypto.

Enligt honom måste dessa situationer hanteras noggrant för att undvika att påverka kontinuerlig innovation.

“Om du skyller på denna entreprenör skulle det döda innovationer eftersom folk skulle vara rädda. Men om det fungerar på ett dåligt sätt, rätt, kan det så småningom fungera. Vi behöver ha ett sätt att stoppa det, lära oss, förbättra och lära om,” tillade Grachev.

Den tunna linjen förblir dock mycket tunn, särskilt i mer extrema scenarier.

Hantera förtroendeproblem för ansvarsfull AI-användning

En vanlig rädsla när man diskuterar framtiden för artificiell intelligens handlar om situationer där AI-agenter blir mäktigare än människor.

“Det finns många filmer om det. Om vi pratar om, låt oss säga, polis eller regeringskontroller, eller någon armé i någon form av krig, är automatisering självklart en stor skräck. Vissa saker kan automatiseras till en så stor nivå att de kan skada människor,” sa Grachev.

När han blev tillfrågad om ett sådant scenario kunde inträffa, sa Grachev att det teoretiskt sett kunde hända. Oavsett erkände han att han inte kunde veta vad som skulle hända i framtiden.

Men sådana situationer är symboliska för de grundläggande förtroendeproblemen mellan människor och artificiell intelligens. Grachev säger att det bästa sättet att närma sig detta problem är att exponera människor för användningsfall där AI faktiskt kan vara till hjälp.

“AI kan vara svårt för människor att tro på. Därför bör det börja med något enkelt, eftersom förtroendet för AI-agenten inte byggs när någon förklarar att den är pålitlig. Människor bör vänja sig vid att använda det. Till exempel, om du pratar om krypto, kan du lansera ett meme, låt oss säga på Pump.fun, men varför inte lansera det med röstmeddelande? Med AI-agenter, skicka bara ett röstmeddelande som säger ‘vänligen lansera detta och det,’ och det är lanserat. Och sedan nästa steg [skulle vara] att lita på agenten med några viktigare beslut,” sa han.

Slutligen kommer resan mot utbredd AI-användning utan tvekan att präglas av anmärkningsvärda framsteg och oförutsedda utmaningar.

Att balansera innovation med ansvarsfull implementering i denna utvecklande sektor kommer att vara avgörande för att forma en framtid där AI gynnar hela mänskligheten.